Medtem ko se navajamo na robote, ki so vešči verbalne komunikacije, deloma zaradi napredka v velikih jezikovnih modelih, kot je ChatGPT, njihove neverbalne komunikacijske sposobnosti, zlasti obrazna mimika, močno zaostajajo. Načrtovanje robota, ki ve, kdaj uporabiti določene obrazne poteze, je bila zastrašujoča naloga.

Kako robot posnema obrazno mimiko človeka?

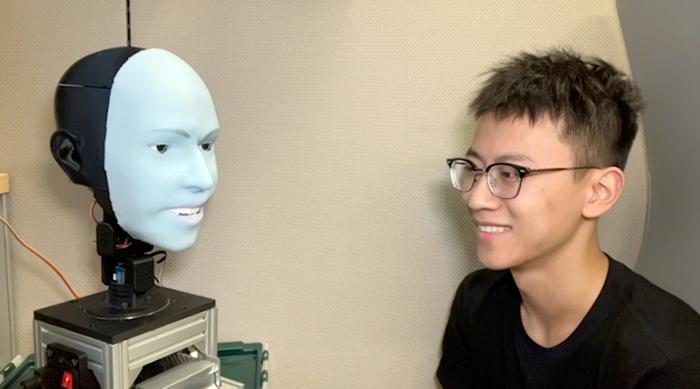

Creative Machines Lab pri Columbia Engineering se s tem izzivom ukvarja že več kot pet let. V novi študiji skupina raziskovalcev razkrije Ema, robota, ki predvideva izraze obraza in jih izvaja sočasno s človekom. Naučil se je celo napovedati prihajajoči nasmeh približno 840 milisekund preden se oseba nasmehne in nasmeh izraziti sočasno z osebo.

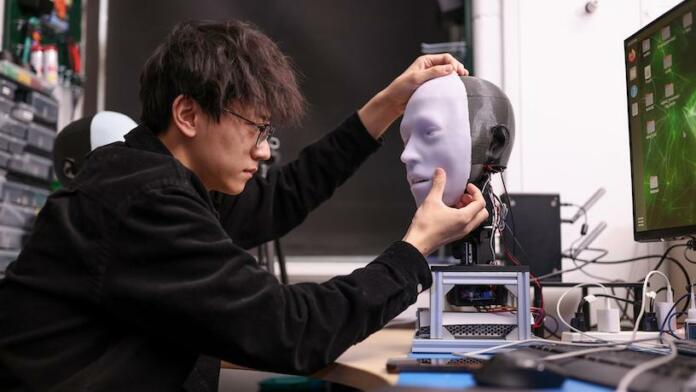

Ekipa, ki jo vodi Hod Lipson, vodilni raziskovalec na področju umetne inteligence in robotike, se je soočila z dvema izzivoma: kako mehansko oblikovati ekspresivno vsestranski robotski obraz, ki vključuje zapleteno strojno opremo in mehanizme za aktiviranje, in vedeti, kateri izraz ustvariti tako, da je videti naraven, pravočasen in pristen. Čas izrazov je bil kritičen – zapoznela obrazna mimika je videti neiskrena, vendar se obrazno soizražanje zdi bolj pristno, saj zahteva pravilno sklepanje o človekovem čustvenem stanju za pravočasno izvedbo.

Kako se Emo poveže s tabo?

Emo je človeku podobna glava z obrazom, ki je opremljen s 26 aktuatorji, ki omogočajo širok razpon niansiranih obraznih izrazov. Glava je prekrita z mehko silikonsko kožo z magnetnim pritrdilnim sistemom, ki omogoča enostavno prilagajanje in hitro vzdrževanje. Za bolj realistične interakcije so raziskovalci integrirali kamere visoke ločljivosti v zenico vsakega očesa, kar je Emu omogočilo očesni stik, ki je ključnega pomena za neverbalno komunikacijo.

Ekipa je razvila dva modela umetne inteligence: enega, ki napoveduje človeško obrazno mimiko z analizo subtilnih sprememb na ciljnem obrazu, in drugega, ki generira motorične ukaze z uporabo ustreznih obraznih izrazov.

Da bi robota naučili delati obrazne mimike, so raziskovalci Ema postavili pred kamero in mu pustili, da izvaja naključne gibe. Po nekaj urah se je robot naučil razmerja med obrazno mimiko in motoričnimi ukazi – podobno kot ljudje vadijo obrazno mimiko s pogledom v ogledalo. To je tisto, kar ekipa imenuje samomodeliranje – podobno naši človeški sposobnosti, da si predstavljamo, kako izgledamo, ko naredimo določene izraze.

Nato je ekipa predvajala videoposnetke človeških obraznih izrazov, da jih je Emo opazoval sličico za sličico. Po treningu, ki traja nekaj ur, je Emo lahko predvidel mimiko ljudi tako, da je opazoval drobne spremembe na njihovih obrazih, ko se začnejo nasmehniti.

»Tradicionalno roboti niso bili zasnovani za upoštevanje človeških izrazov med interakcijami. Zdaj lahko robot integrira človeške obrazne izraze kot povratno informacijo,« je povedal glavni avtor študije Yuhang Hu, doktorski študent na Columbia Engineering v Lipsonovem laboratoriju. »Ko se robot so-izraža z ljudmi v realnem času, ne le izboljša kakovost interakcije, ampak tudi pomaga pri vzpostavljanju zaupanja med ljudmi in roboti.«

Novinar